jueves, 23 de febrero de 2017

cual es la mejor manera de explicar un algoritmo?

23/02/2017

EJEMPLO

Proceso numeros_pares_impares

contador<-0

contadorPar<-0

contadorImpar<-1

sumaPar<-0

sumaImpar<-0

Mientras contadorPar<2000 Hacer

Si (contador MOD 2)=0 Entonces

sumaPar<-sumaPar+contador

contadorPar<-contadorPar+1

Sino

Si contadorImpar<=1000 Entonces

sumaImpar<-sumaImpar+contador

contadorImpar<-contadorImpar+1

FinSi

FinSi

contador<-contador+1

FinMientras

Escribir 'Suma de Pares: ',sumaPar

Escribir 'Suma Impares: ',sumaImpar

FinProceso

comandos pseudocodigo Pseint

COMANDO LEER

Es el que se utiliza para poder ingresar o el que nos guarda los datos los a la hora de ejecutar el ejercicio de prueba.

Botón en Pseint

COMANDO ESCRIBIR

Este comando se utiliza para que nos muestre el resultado al final de la ejecución del ejercicio de prueba.

Botón en Pseint

COMANDO ASIGNAR

La instrucción de asignación permite almacenar una valor en una variable.

<Variable> <- <expresión>;

Botón en Pseint

CONDICIONAL SI-ENTONCES

La secuencia de instrucciones ejecutadas por la instrucción Si-Entonces-Sino depende del valor de una condición lógica.

Si <condición>

Entonces

<instrucciones>

Sino

<instrucciones>

FinSi

si la condición es verdadera, o las instrucciones que le siguen al Sino si la condición es falsa. La condición debe ser una expresión lógica, que al ser evaluada retorna Verdadero o Falso.

Botón en Pseint

CICLO MIENTRAS (WHILE)

La instrucción Mientras ejecuta una secuencia de instrucciones mientras una condición sea verdadera.

Mientras <condición> Hacer

<instrucciones>

FinMientras

Si la condición resulta verdadera, se ejecuta una vez la secuencia de instrucciones que forman el cuerpo del ciclo. Al finalizar la ejecución del cuerpo del ciclo se vuelve a evaluar la condición y, si es verdadera, la ejecución se repite. Estos pasos se repiten mientras la condición sea verdadera.

Botón en Pseint

CICLO REPETIR (DO WHILE)

La instrucción Repetir-Hasta Que ejecuta una secuencia de instrucciones hasta que la condición sea verdadera.

Repetir

<instrucciones>

Hasta Que <condición>

Si la condición es falsa, el cuerpo del ciclo se ejecuta nuevamente y se vuelve a evaluar la condición. Esto se repite hasta que la condición sea verdadera.

Botón en Pseint

Usaremos hacer hasta cuando la estructura mientras no pueda utilizarse por qué un bloque de programa que quizás se repita, deba ejecutarse almeno una vez.

CICLO PARA

La instrucción Para ejecuta una secuencia de instrucciones un número determinado de veces.

Para <variable> <- <inicial> Hasta <final> ( Con Paso <paso> ) Hacer

<instrucciones>

FinPara

consta de la variable donde se coloca la variable ya declarada recibe el valor inicial y se ejecuta la secuencia de instrucciones que forma el cuerpo del ciclo. Luego se incrementa la variable en paso que es donde colocamos en qué tipo de paso vaya aumentado o disminuido si es aumentado seria con paso de 1 o 2 como nosotros queramos y si es disminuido con paso de -1 o -2 etc. final en este colocamos hasta donde queremos que termine el ciclo.

Botón en Pseint

CALIDAD DE LA INFORMACION

Si no hay conciencia en la necesidad de la calidad sobre la velocidad o facilidad de uso para el usuario, es probable que el sistema de información quede produciendo a altas velocidades cifras irrelevantes que ocasionen errores en las decisiones.

Ya está comprobado que contamos con suficientes herramientas para obtener información, almacenarla, procesarla y presentar sus resultados. Sin embargo la disponibilidad de la tecnología y la facilidad de acopio y procesamiento nos hacen olvidar un poco en temas de calidad de la misma información. Nos concentramos tanto en el conseguir y procesar y dejamos un poco de lado la calidad de la información que estamos obteniendo.

Ya está comprobado que contamos con suficientes herramientas para obtener información, almacenarla, procesarla y presentar sus resultados. Sin embargo la disponibilidad de la tecnología y la facilidad de acopio y procesamiento nos hacen olvidar un poco en temas de calidad de la misma información. Nos concentramos tanto en el conseguir y procesar y dejamos un poco de lado la calidad de la información que estamos obteniendo.Los datos que recopilamos sufren varias transformaciones dese el momento que se obtiene hasta el momento que se presenta para toma de decisiones. Por lo general los datos se capturan, se almacenan, se procesa, y se presenta el resultado como información. Existen algunas herramientas que pueden facilitar garantizar la calidad de la misma, pero también se requiere conciencia en quien está trabajando con la información de la importancia de la fidelidad de la misma.

El manejo de la calidad de la información se da desde la captura de la misma. En la captura de los datos se ha trabajado enormemente en funcionalidad de validación, que permita al sistema ayudar en la revisión de la validez de los datos que se están incorporando al sistema. De la misma manera hay dispositivos que capturan en forma “automática” los datos de las transacciones.

Los lectores de códigos de barras, por ejemplo, es una de estas herramientas muy útiles en la captura fiel de la información, sin embargo para garantizar la calidad de la información, se le debe “ayudar” tanto garantizando que los productos o documentos a escanear están bien etiquetados, y además que en el proceso de toma de información, solo se utiliza el escáner.

Es común en un almacén, que la cajera en aras de “agilidad” pase cuatro cajas aparentemente del mismo precio (cuatro chocolates, o cuatro cajas de gelatina por ejemplo) marcando un cuatro en el teclado de la registradora y luego seleccionando el código del producto con la pistola o el escáner de la mesa. Esto desconoce la posibilidad de almacenar o dar de baja productos por color o por sabor, generando un error grave en la captura de la información, y por ende en lo que de ahí se desprenderá.

Sin embargo si el operario no tiene un claro entendimiento de lo importante de la fidelidad de la información, es probable que el problema de calidad no esté en la tecnología sino en las políticas para el manejo de los datos.

Por otro lado, si hay herramientas que permiten validar de cierto modo la información. Es mucho más confiable que se seleccione el nombre de un país o una ciudad, que se tenga que digitar. Pero también es fácil seleccionar un país encima o debajo del que realmente es. Se hace entonces necesario también efectuar cruces en la toma de la información, para que cruzando por ejemplo, con otra información que se digite se pueda validar errores en la información.

El almacenamiento de la información debe hacerse en forma celosa, impidiendo que la información sea manipulada por elementos que no dejen rastro de dicha manipulación. Es muy importante que si se van a modificar ciertos datos, quede registro de esta modificación para luego, en caso que sea necesario, se pueda recurrir a la información base.

En muchas ocasiones hay que ajustar información tomada en la fuente, corrigiendo errores de entrada, o simplemente consolidando información para que Calle, Cl, y Clle reflejen todas Calle en una dirección física. Estos cambios deben quedar también registrados, porque en esta manipulación también se puede incurrir en errores.

Adicionalmente debemos tener cuidado con información adicional que permita identificar de cuándo es la información almacenada, a qué períodos corresponde para poderla usar en análisis de tendencias y comparativa. El número por si solo no sirve mucho si no se sabe a qué corresponde y de cuando es.

Por último está el proceso de consolidación y presentación de información gerencial, o de consulta, o reportes, a partir de la información capturada y almacenada. Si los dos primeros pasos no se cuidan celosamente, el nivel de confiabilidad sobre la información producida será menor al deseado.

El proceso de producción de información también debe ser auditable para identificar que tanto las fuentes como los resultados realmente obedecen a los criterios para establecer la información final. Que el concepto de Ventas sea claro para todos, no que para unos sea la inclusión de pedidos en el sistema, y para otros sea los pedidos ya facturados únicamente.

Afortunadamente el factor de Calidad se puede y se debe diseñar mediante la implementación de procesamiento automático de información, establecimiento de seguridades a diferentes niveles, y la auditabilidad de las actividades, específicamente identificando quién hizo qué, cuándo y desde donde.

Las bases de datos actualmente proveen herramientas como la integridad referencial, sin embargo si no hay conciencia en la necesidad de la calidad sobre la velocidad o facilidad de uso para el usuario, es probable que el sistema de información quede produciendo a altas velocidades cifras irrelevantes que ocasionen errores en las decisiones

EL DEBATE

se hablaron sobre muchas cosas de traer ideas de otros paises y trasformarlas otro grupo se expecifico en los los odjetivos son muy importantes , saber responder preguntas ,la conclusión a la que e llegado con los debates; es que la calidad de un sistema de información no solo se basa en su aspecto o su capacidad para resolver un problema; sino que también requiere una sinergia con muchos otros factores como lo es : la accesibilidad, la comprensión, la satisfacción del cliente, etc.... y que no podemos pretender que uno de ellos valga menos que los demás puesto que en lo que respecta a calidad todos los factores son necesarios incluso los que parecerían relevantes.

martes, 21 de febrero de 2017

TIPOS DE DATOS - PSEUDOCODIGO-DIAGRAMA DE FLUJO

TIPOS DE DATOS

es la propiedad de un valor que determina su dominio (qué valores puede tomar), qué operaciones se le pueden aplicar y cómo es representado internamente por el computador. Todos los valores que aparecen en un programa tienen un tipo. A continuación revisaremos los tipos de datoselementales de Python.

PSEUDOCODIGO

el pseudocódigo (o falso lenguaje) es una descripción de alto nivel compacta e informal del principio operativo de un programa informático u otro algoritmo.

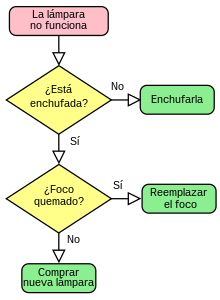

DIAGRAMAS DE FLUJO

Un diagrama de flujo es una representación gráfica de un proceso. Cada paso del proceso es representado por un símbolo diferente que contiene una breve descripción de la etapa de proceso. Los símbolos gráficos del flujo del proceso están unidos entre sí con flechas que indican la dirección de flujo del proceso

https://www.aiteco.com/que-es-un-diagrama-de-flujo/

miércoles, 15 de febrero de 2017

ALGORITMO

En matemáticas, lógica, ciencias de la computación y disciplinas relacionadas, un algoritmo (del griego y latín, dixit algorithmus y este a su vez del matemático persa Al-Juarismi)1 es un conjunto prescrito de instrucciones o reglas bien definidas, ordenadas y finitas que permite llevar a cabo una actividad mediante pasos sucesivos que no generen dudas a quien deba hacer dicha actividad.2 Dados un estado inicial y una entrada, siguiendo los pasos sucesivos se llega a un estado final y se obtiene una solución. Los algoritmos son el objeto de estudio de la algoritmia.1

En la vida cotidiana, se emplean algoritmos frecuentemente para resolver problemas. Algunos ejemplos son los manuales de usuario, que muestran algoritmos para usar un aparato, o las instrucciones que recibe un trabajador por parte de su patrón. Algunos ejemplos en matemática son el algoritmo de multiplicación, para calcular el producto, el algoritmo de la división para calcular el cociente de dos números, el algoritmo de Euclides para obtener el máximo común divisor de dos enteros positivos, o el método de Gauss para resolver un sistema de ecuaciones lineales.

En términos de programación, un algoritmo es una secuencia de pasos lógicos que permiten solucionar un problema.

ALGORITMO COMO HACER UN AVION DE PAPEL

1

Utiliza una hoja de papel regular de tamaño A4 o carta. Este es el papel para impresión estándar y mide 21,5 x 28 cm (8,5 x 11 pulgadas). El papel debe ser rectangular y no cuadrado o recortado.

2

Dobla el papel a la mitad. Al doblar, la orientación del papel debe ser vertical y el pliegue debe ser a lo largo de este lado medio y más largo. Asegúrate de que las esquinas coincidan.

- Utiliza el pulgar o una herramienta de borde plano, como un cuchillo de cocina o un depresor lingual de madera para plegar el papel. Cuando hagas un avión de papel de cualquier tipo, asegúrate de que los pliegues sean definidos.[3]

- Desdobla el papel. No le des la vuelta.

3

Dobla las dos esquinas superiores hacia el pliegue central. Los bordes del papel deben estar alineados de la manera más exacta posible con el pliegue del medio. Los dos bordes exteriores del papel deben tocarse entre sí en la línea del pliegue.

- Esto debe formar solapas triangulares en cada lado del papel. La parte superior debe tener la forma de una punta.

- La parte inferior de la solapa debe ser una línea recta.

4

Dobla nuevamente la solapa hacia la mitad del papel. Toma la esquina superior del borde exterior y dóblala hacia el centro. Al igual que en el paso 3, los bordes deben unirse a lo largo del pliegue vertical en el medio.

- El papel debe tener la apariencia de un dardo, con una solapa triangular mucho más estrecha en cada lado. Ahora la mayor parte del papel tendrá la forma de un triángulo, con una punta en la parte superior.

5

Dobla el papel a la mitad. Al doblar el papel a la mitad, realiza el pliegue a lo largo del pliegue vertical. Dobla un lado del papel sobre la parte superior del otro, de modo que encajen con exactitud. Pasa el dedo o una herramienta de borde romo a lo largo del pliegue para hacerlo más definido.

en el salon hicimos un grupos en algoritmos de aviones de papel y casi ninguno logro hacerlo

en el salon hicimos un grupos en algoritmos de aviones de papel y casi ninguno logro hacerlo

martes, 14 de febrero de 2017

lunes, 13 de febrero de 2017

PROPOSICIONES LOGICAS

Una proposición es una oración con valor referencial o informativo, de la cual se puede predicar su veracidad o falsedad, es decir, que puede ser falsa o verdadera pero no ambas a la vez.

La proposición es la expresión lingüística del razonamiento, que se caracteriza por ser verdadera o falsa empíricamente, sin ambigüedades. Son proposiciones las oraciones aseverativas, las leyes científicas, las fórmulas matemáticas, las fórmulas y/o esquemas lógicos, los enunciados cerrados o claramente definidos. No son proposiciones las opiniones y suposiciones; los proverbios, modismos y refranes; los enunciados abiertos no definidos; las oraciones interrogativas, exclamativas, imperativas, desiderativas y dubitativas; las interjecciones en general; ni las operaciones aritméticas.

EJEMPLOS

1,

a.145+184=329 v

b. hay varias razas de perros v

a b a&b

v-v v

2.

a. la musica tiene varios generos v

b. 2 elevado 2 es 6 f

a b a&b

v-f f

3.

a. los peces respiran v

b.hoy es martes v

c.la tierra es cuadrada f

(a&b)&c)

(v)&f)

a & b c a&b&c

v f f

HISTORIA ORIGEN Y EVOLUCIÓN DEL COMPUTADOR

1.La primera máquina de calcular mecánica, un precursor del ordenador digital, fue inventada en 1642 por el matemático francés Blaise Pascal. Aquel dispositivo utilizaba una serie de ruedas de diez dientes en las que cada uno de los dientes representaba un dígito del 0 al 9. Las ruedas estaban conectadas de tal manera que podían sumarse números haciéndolas avanzar el número de dientes correcto. En 1670 el filósofo y matemático alemán Gottfried Wilhelm Leibniz perfeccionó esta máquina e inventó una que también podía multiplicar.

El inventor francés Joseph Marie Jacquard, al diseñar un telar automático, utilizó delgadas placas de madera perforadas para controlar el tejido utilizado en los diseños complejos. Durante la década de 1880 el estadístico estadounidense Herman Hollerith concibió la idea de utilizar tarjetas perforadas, similares a las placas de Jacquard, para procesar datos. Hollerith consiguió compilar la información estadística destinada al censo de población de 1890 de Estados Unidos mediante la utilización de un sistema que hacía pasar tarjetas perforadas sobre contactos eléctricos.

El mundo de la alta tecnología nunca hubiera existido de no ser por el desarrollo del ordenador o computadora. Toda la sociedad utiliza estas máquinas, en distintos tipos y tamaños, para el almacenamiento y manipulación de datos. Los equipos informáticos han abierto una nueva era en la fabricación gracias a las técnicas de automatización, y han permitido mejorar los sistemas modernos de comunicación. Son herramientas esenciales prácticamente en todos los campos de investigación y en tecnología aplicada.

También en el siglo XIX el matemático e inventor británico Charles Babbage elaboró los principios de la computadora digital moderna. Inventó una serie de máquinas, como la máquina diferencial, diseñadas para solucionar problemas matemáticos complejos.

Muchos historiadores consideran a Babbage y a su socia, la matemática británica Augusta Ada Byron (1815-1852), hija del poeta inglés Lord Byron, como a los verdaderos inventores de la computadora digital moderna.

La tecnología de aquella época no era capaz de trasladar a la práctica sus acertados conceptos; pero una de sus invenciones, la máquina analítica, ya tenía muchas de las características de un ordenador moderno.

Incluía una corriente, o flujo de entrada en forma de paquete de tarjetas perforadas, una memoria para guardar los datos, un procesador para las operaciones matemáticas y una impresora para hacer permanente el registro.

Considerada por muchos como predecesora directa de los modernos dispositivos de cálculo, la máquina diferencial era capaz de calcular tablas matemáticas. Este corte transversal muestra una pequeña parte de la ingeniosa máquina diseñada por el matemático británico Charles Babbage en la década de 1820. La máquina analítica, ideada también por Babbage, habría sido una auténtica computadora programable si hubiera contado con la financiación adecuada. Las circunstancias quisieron que ninguna de las máquinas pudieran construirse durante su vida, aunque esta posibilidad estaba dentro de la capacidad tecnológica de la época. En 1991, un equipo del Museo de las Ciencias de Londres consiguió construir una máquina diferencial Nº 2 totalmente operativa, siguiendo los dibujos y especificaciones de Babbage.

Los ordenadores analógicos comenzaron a construirse a principios del siglo XX. Los primeros modelos realizaban los cálculos mediante ejes y engranajes giratorios. Con estas máquinas se evaluaban las aproximaciones numéricas de ecuaciones demasiado difíciles como para poder ser resueltas mediante otros métodos. Durante las dos guerras mundiales se utilizaron sistemas informáticos analógicos, primero mecánicos y más tarde eléctricos, para predecir la trayectoria de los torpedos en los submarinos y para el manejo a distancia de las bombas en la aviación.

Durante la II Guerra Mundial (1939-1945), un equipo de científicos y matemáticos que trabajaban en Bletchley Park, al norte de Londres, crearon lo que se consideró el primer ordenador digital totalmente electrónico: el Colossus. Hacia diciembre de 1943 el Colossus, que incorporaba 1.500 válvulas o tubos de vacío, era ya operativo. Fue utilizado por el equipo dirigido por Alan Turing para descodificar los mensajes de radio cifrados de los alemanes. En 1939 y con independencia de este proyecto, John Atanasoff y Clifford Berry ya habían construido un prototipo de máquina electrónica en el Iowa State College (EEUU). Este prototipo y las investigaciones posteriores se realizaron en el anonimato, y más tarde quedaron eclipsadas por el desarrollo del Calculador e integrador numérico electrónico (en inglés ENIAC, Electronic Numerical Integrator and Computer) en 1945. El ENIAC, que según se demostró se basaba en gran medida en el ordenador Atanasoff-Berry (en inglés ABC, Atanasoff-Berry Computer), obtuvo una patente que caducó en 1973, varias décadas más tarde.

La primera computadora electrónica comercial, la UNIVAC I, fue también la primera capaz de procesar información numérica y textual. Diseñada por J. Presper Eckeret y John Mauchly, cuya empresa se integró posteriormente en Remington Rand, la máquina marcó el inicio de la era informática. En la ilustración vemos una UNIVAC. La computadora central está al fondo, y en primer plano puede verse al panel de control de supervisión. Remington Rand entregó su primera UNIVAC a la Oficina del Censo de Estados Unidos en 1951.

5. El eniac

El ENIAC contenía 18.000 válvulas de vacío y tenía una velocidad de varios cientos de multiplicaciones por minuto, pero su programa estaba conectado al procesador y debía ser modificado manualmente. Se construyó un sucesor del ENIAC con un almacenamiento de programa que estaba basado en los conceptos del matemático húngaro-estadounidense John von Neumann. Las instrucciones se almacenaban dentro de una llamada memoria, lo que liberaba al ordenador de las limitaciones de velocidad del lector de cinta de papel durante la ejecución y permitía resolver problemas sin necesidad de volver a conectarse al ordenador.

A finales de la década de 1950 el uso del transistor en los ordenadores marcó el advenimiento de elementos lógicos más pequeños, rápidos y versátiles de lo que permitían las máquinas con válvulas. Como los transistores utilizan mucha menos energía y tienen una vida útil más prolongada, a su desarrollo se debió el nacimiento de máquinas más perfeccionadas, que fueron llamadas ordenadores o computadoras de segunda generación. Los componentes se hicieron más pequeños, así como los espacios entre ellos, por lo que la fabricación del sistema resultaba más barata.

6. Circuitos integrados

A finales de la década de 1960 apareció el circuito integrado (CI), que posibilitó la fabricación de varios transistores en un único sustrato de silicio en el que los cables de interconexión iban soldados. El circuito integrado permitió una posterior reducción del precio, el tamaño y los porcentajes de error. El microprocesador se convirtió en una realidad a mediados de la década de 1970, con la introducción del circuito de integración a gran escala (LSI, acrónimo de Large Scale Integrated) y, más tarde, con el circuito de integración a mayor escala (VLSI, acrónimo de Very Large Scale Integrated), con varios miles de transistores interconectados soldados sobre un único sustrato de silicio.

Los circuitos integrados han hecho posible la fabricación del microordenador o microcomputadora. Sin ellos, los circuitos individuales y sus componentes ocuparían demasiado espacio como para poder conseguir un diseño compacto. También llamado chip, un circuito integrado típico consta de varios elementos como reóstatos, condensadores y transistores integrados en una única pieza de silicio. En los más pequeños, los elementos del circuito pueden tener un tamaño de apenas unos centenares de átomos, lo que ha permitido crear sofisticadas computadoras del tamaño de un cuaderno. Una placa de circuitos de una computadora típica incluye numerosos circuitos integrados interconectados entre sí.

La necesidad del hombre de encontrar métodos rápidos y efectivos para resolver sus cálculos y su gran inventiva lo llevaron a través de los siglos al desarrollo de lo que hoy conocemos como la computadora. Desde el ábaco hasta las computadoras personales éstas han tenido una gran influencia en diferentes aspectos de nuestro diario vivir, mejorando nuestra calidad de vida y abriendo puertas que antes eran desconocidas para la humanidad.

500 AC: Ábaco

El primer calculador de tipo mecánico fue ideado en Babilonia alrededor de 500 A.C. Este dispositivo mecánico llamado ábaco consistía de un sistema de barras y poleas con lo cual se podían efectuar diferentes tipos de cálculos aritméticos.

1622: Oughtred presenta la regla de cálculo

Hacia 1622, el matemático inglés William Oughtred utilizó los recién inventados logaritmos para fabricar un dispositivo que simplificaba la multiplicación y la división. Consistía en dos reglas graduadas unidas que se deslizaban una sobre otra.

1642: Primera máquina de sumar

El matemático y filósofo francés Blaise Pascal tenía diecinueve años cuando construyó la primera máquina sumadora del mundo en 1642. Utilizaba un engranaje de ruedas dentadas como contadores. El dispositivo llevaba 1 automáticamente al llegar a las decenas y también podía emplearse para restar.

1834: Primera computadora digital programable

En 1834 el científico e inventor inglés Charles Babbage realizó los esquemas de un dispositivo el cual llamó máquina analítica lo que en realidad era una computadora de propósitos generales. Esta máquina era programada por una serie de tarjetas perforadas que contenían datos o instrucciones las cuales pasaban a través de un dispositivo de lectura, eran almacenados en una memoria y los resultados eran reproducidos por unos moldes. Esta máquina superaba por mucho la tecnología de su tiempo y nunca se terminó.

1850: Primera sumadora de teclado

El teclado apareció en una máquina inventada en Estados Unidos en 1850. Podían sumarse una secuencia de dígitos pulsando unas teclas sucesivas. Cada tecla alzaba un eje vertical a cierta altura y la suma quedaba indicada por la altura total.

8. Generaciones Del Computador

- Dotación física

- Mecánico

- Software lógica

- Tarjetas o cinta de papel perforadas

- Ada Lovelace - primer programador (c. 1840)

- Máquina de Turing y Church-Turing Thesis (1937)

- Máquinas Especiales

- Ábaco

- Pascaline - Primera Máquina calculadora Automática (1642)

- Telar De Telar jacquar (1805)

- Motores De Babbage

- Motor De Diferencia (1822)

- Motor Analítico (1832)

- Hollerith

- Máquina De Tabulación (Censo 1890 De los E.E.U.U.)

- La máquina de tabulación de las formas Co. (1896) - se convierte la IBM en 1924

- Máquina sumadora De Burroughs (1888)

- Dotación física

- Tubos de vacío

- Tambores magnéticos

- Cinta magnética (cerca del extremo de la generación)

- Software lógica

- Programas en terminología de la informática

- Programas en lenguaje ensamblador (cerca del extremo de la generación)

- 1946 - von Neumann publica el documento sobre el ordenador salvado del programa

- 1950 - Prueba de Turing publicada

- Máquinas Especiales

- 1940 - ABC (1r ordenador electrónico)

- 1940 - Robinson (1r ordenador, código operacionales de Enigma de las grietas)

- 1946 - Calculadora numérica de ENIAC (1r completamente electrónico, de uso general)

- 1950 - UNIVAC I (1r ordenador comercialmente acertado)

- Dotación física

- Transistores

- 1947 - Convertido

- 1955 - Calculadora Del Transistor De IBM's

- Minicomputadoras

- Discos magnéticos

- Tarjetas de circuito impresas

- Software lógica

- Lenguajes de alto nivel

- 1956 - FORTRAN

- 1959 - COBOL

- Máquinas Especiales

- 1963 -- PDP 8 (1ra minicomputadora)

- Dotación física

- Circuitos integrados (c. desarrollada 1958)

- Familias de los ordenadores (1964 - IBM 360)

- 1970 - Diskette

- Software lógica

- Los programas entraron directamente en los ordenadores

- Lenguajes de un nivel más alto (1965 - BASIC)

- Sistemas operativos

- Timesharing

- Máquinas Especiales

- 1964 -- Serie del sistema 360 de la IBM (1ra familia de ordenadores)

13. Cuarta generación: C. 1971 – PRESENTE

- Dotación física

- 1971 - Viruta del microprocesador introducida en los E.E.U.U. por Intel

- Microordenadores (Ordenadores Personales)

- Integración De la Escala Grande (LSI)

- Integración De la Escala Muy Grande (Vlsi)

- Software lógica

- Programación estructurada

- Conjuntos de aplicación

- Sistemas del windowing (interfaces utilizador gráficos -- GUIs)

- Programas conviviales

- Máquinas Especiales

- 1971 - (1ra calculadora de bolsillo)

- 1975 -- Altaír 8800 (1ra PC)

- 1977 -- Manzana I (hágala usted mismo kit)

- 1978 -- Manzana II (premontada)

- 1981 -- PC DE LA IBM

- 1984 -- Impermeable

- Dotación física

- Más pequeño

- Más rápidamente

- Más barato

- Más disponible

- Software lógica

El ordenador analógico es un dispositivo electrónico o hidráulico diseñado para manipular la entrada de datos en términos de, por ejemplo, niveles de tensión o presiones hidráulicas, en lugar de hacerlo como datos numéricos. El dispositivo de cálculo analógico más sencillo es la regla de cálculo, que utiliza longitudes de escalas especialmente calibradas para facilitar la multiplicación, la división y otras funciones. En el típico ordenador analógico electrónico, las entradas se convierten en tensiones que pueden sumarse o multiplicarse empleando elementos de circuito de diseño especial. Las respuestas se generan continuamente para su visualización o para su conversión en otra forma deseada.

Todo lo que hace un ordenador digital se basa en una operación: la capacidad de determinar si un conmutador, o ‘puerta’, está abierto o cerrado. Es decir, el ordenador puede reconocer sólo dos estados en cualquiera de sus circuitos microscópicos: abierto o cerrado, alta o baja tensión o, en el caso de números, 0 o 1. Sin embargo, es la velocidad con la cual el ordenador realiza este acto tan sencillo lo que lo convierte en una maravilla de la tecnología moderna. Las velocidades del ordenador se miden en megahercios, o millones de ciclos por segundo. Un ordenador con una velocidad de reloj de 100 MHz, velocidad bastante representativa de un microordenador o microcomputadora, es capaz de ejecutar 100 millones de operaciones discretas por segundo. Las microcomputadoras de las compañías pueden ejecutar entre 150 y 200 millones de operaciones por segundo, mientras que las supercomputadoras utilizadas en aplicaciones de investigación y de defensa alcanzan velocidades de miles de millones de ciclos por segundo.

La velocidad y la potencia de cálculo de los ordenadores digitales se incrementan aún más por la cantidad de datos manipulados durante cada ciclo. Si un ordenador verifica sólo un conmutador cada vez, dicho conmutador puede representar solamente dos comandos o números. Así, ON simbolizaría una operación o un número, mientras que OFF simbolizará otra u otro. Sin embargo, al verificar grupos de conmutadores enlazados como una sola unidad, el ordenador aumenta el número de operaciones que puede reconocer en cada ciclo. Por ejemplo, un ordenador que verifica dos conmutadores cada vez, puede representar cuatro números (del 0 al 3), o bien ejecutar en cada ciclo una de las cuatro operaciones, una para cada uno de los siguientes modelos de conmutador: OFF-OFF (0), OFF-ON (1), ON-OFF (2) u ON-ON (3). En general, los ordenadores de la década de 1970 eran capaces de verificar 8 conmutadores simultáneamente; es decir, podían verificar ocho dígitos binarios, de ahí el término bit de datos en cada ciclo.

Un grupo de ocho bits se denomina byte y cada uno contiene 256 configuraciones posibles de ON y OFF (o 1 y 0). Cada configuración equivale a una instrucción, a una parte de una instrucción o a un determinado tipo de dato; estos últimos pueden ser un número, un carácter o un símbolo gráfico. Por ejemplo, la configuración 11010010 puede representar datos binarios, en este caso el número decimal 210 , o bien estar indicando al ordenador que compare los datos almacenados en estos conmutadores con los datos almacenados en determinada ubicación del chip de memoria. El desarrollo de procesadores capaces de manejar simultáneamente 16, 32 y 64 bits de datos ha permitido incrementar la velocidad de los ordenadores. La colección completa de configuraciones reconocibles, es decir, la lista total de operaciones que una computadora es capaz de procesar, se denomina conjunto, o repertorio, de instrucciones. Ambos factores, el número de bits simultáneos y el tamaño de los conjuntos de instrucciones, continúa incrementándose a medida que avanza el desarrollo de los ordenadores digitales modernos.

17. Evolución futura

Una tendencia constante en el desarrollo de los ordenadores es la microminiaturización, iniciativa que tiende a comprimir más elementos de circuitos en un espacio de chip cada vez más pequeño. Además, los investigadores intentan agilizar el funcionamiento de los circuitos mediante el uso de la superconductividad, un fenómeno de disminución de la resistencia eléctrica que se observa cuando se enfrían los objetos a temperaturas muy bajas.

Las redes informáticas se han vuelto cada vez más importantes en el desarrollo de la tecnología de computadoras. Las redes son grupos de computadoras interconectados mediante sistemas de comunicación. La red pública Internet es un ejemplo de red informática planetaria. Las redes permiten que las computadoras conectadas intercambien rápidamente información y, en algunos casos, compartan una carga de trabajo, con lo que muchas computadoras pueden cooperar en la realización de una tarea. Se están desarrollando nuevas tecnologías de equipo físico y soporte lógico que acelerarán los dos procesos mencionados.

Otra tendencia en el desarrollo de computadoras es el esfuerzo para crear computadoras de quinta generación, capaces de resolver problemas complejos en formas que pudieran llegar a considerarse creativas. Una vía que se está explorando activamente es el ordenador de proceso paralelo, que emplea muchos chips para realizar varias tareas diferentes al mismo tiempo. El proceso paralelo podría llegar a reproducir hasta cierto punto las complejas funciones de realimentación, aproximación y evaluación que caracterizan al pensamiento humano. Otra forma de proceso paralelo que se está investigando es el uso de computadoras moleculares. En estas computadoras, los símbolos lógicos se expresan por unidades químicas de ADN en vez de por el flujo de electrones habitual en las computadoras corrientes.

Suscribirse a:

Comentarios (Atom)